Faut-il suivre une formation cloud pour propulser votre carrière vers de nouveaux horizons ? L’informatique en nuage s’impose en entreprise, et sa maîtrise devient essentielle pour les professionnels. Découvrez pourquoi et comment acquérir cette expertise !

Afin de profiter de ses nombreux avantages, de plus en plus d’entreprises migrent vers le cloud computing.

Cette technologie apporte des bénéfices considérables en termes de coût, d’évolutivité, d’accessibilité, de sécurité, d’innovation et permet même de réduire son empreinte carbone.

Toutefois, pour en tirer pleinement profit, des compétences techniques sont indispensables. Pour cette raison, suivre une formation cloud permet d’acquérir une expertise très recherchée.

Pourquoi suivre une formation cloud ?

Au cours de la dernière décennie, le cloud a transformé le fonctionnement des entreprises. Même les métiers non techniques migrent vers cette technologie.

De nombreuses entreprises ont remplacé leur infrastructure informatique locale traditionnelle par le cloud computing, et le marché mondial est passé de 24 à 156 milliards de dollars entre 2010 et 2020.

À l’heure actuelle, selon O’Reilley, plus de 90% des organisations utilisent le cloud computing. Et cette tendance va se poursuivre à l’avenir.

Par conséquent, les experts peuvent très facilement trouver un emploi aussi bien dans les petites entreprises qu’au sein des plus larges organisations.

Et les salaires proposés sont attractifs. D’après le BLS des États-Unis, la rémunération annuelle moyenne pour un architecte réseau travaillant sur le cloud atteint par exemple 120 000 dollars.

En France, d’après Talent.com, le salaire annuel moyen pour un administrateur cloud avoisine 40 000 euros.

De manière générale, face à l’adoption massive du cloud en entreprise, une formation est désormais essentielle pour tous les professionnels de l’informatique. Ceci inclut les experts en cybersécurité, en développement de logiciels, en l’ingénierie de données ou même en machine learning.

Commencer une formation cloud

Les différents types de formations cloud

Il existe une large variété de formations cloud. Certaines s’adressent aux utilisateurs finaux, à savoir les professionnels qui utilisent les applications et services cloud.

Ceci inclut les logiciels de traitement de texte, les plateformes de stockage de données ou même les services de vidéoconférence comme Zoom et Microsoft Teams.

L’usage de ces solutions ne requiert pas d’expertise technique majeure, mais nécessite tout de même une compréhension fondamentale du cloud afin de les exploiter de manière optimale.

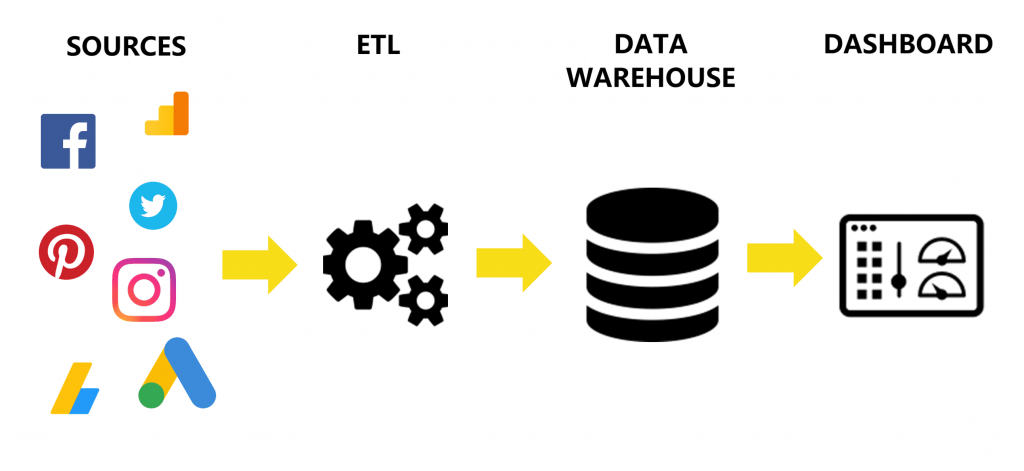

Face à la grande diversité des services, une large variété de professionnels peuvent être amenés à utiliser le cloud. Par exemple, les Data Engineers habitués à des logiciels on-premise doivent apprendre à manier les solutions en nuage.

Il existe aujourd’hui des services cloud pour la bureautique, la gestion de relation client, les RH, la comptabilité, la collaboration, le marketing ou encore le e-commerce. Et les catalogues des fournisseurs sont en constante expansion.

De même, les solutions verticales sont des applications spécifiques à un secteur d’activité visant à répondre à leurs besoins. En guise d’exemple, on peut citer un logiciel de gestion de dossier médical électronique en SaaS pour le secteur de la santé.

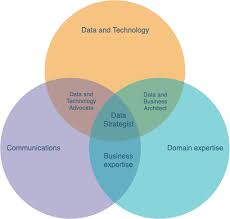

D’autres formations sont conçues pour les professionnels de l’informatique. Il s’agit notamment des administrateurs réseau, des ingénieurs système ou des architectes cloud.

Ce type de cursus leur permet d’acquérir des compétences pour la migration vers le cloud, la gestion des services, la conception d’architectures ou encore la cybersécurité.

En outre, les formations pour développeurs sont dédiées aux personnes souhaitant concevoir et construire des applications et des services cloud.

Elles permettent notamment d’acquérir des compétences en automatisation de processus et en intégration des services cloud.

Quelles compétences acquérir par une formation cloud ?

Une bonne formation cloud doit tout d’abord permettre de comprendre les bases du cloud computing, de découvrir les différentes catégories de services et les principales plateformes existantes.

Le programme doit couvrir les concepts tels que la gestion des identités et la gouvernance, la configuration du réseau virtuel, la gestion du stockage, le déploiement des ressources informatiques ou encore le monitoring.

Elle doit aussi conférer la capacité de diagnostiquer et de résoudre rapidement les problèmes de sécurité, de performance ou de disponibilité affectant les services cloud.

Enfin, les professionnels du cloud doivent être en mesure de travailler en équipe et de communiquer efficacement. Un cursus de qualité doit donc aborder ces notions.

Débuter une formation cloud

Les certifications cloud

Tous les principaux fournisseurs de cloud proposent des certifications permettant de valider la maîtrise de leurs plateformes, ou de services destinés à des métiers spécifiques.

Par exemple, AWS Solutions Architect démontre la capacité à déployer, gérer et utiliser les différents services Amazon Web Services.

Chez Microsoft, la certification AZ-900 Azure Fundamentals requiert une connaissance des principaux services et du fonctionnement de la plateforme. De même, AZ-104 Azure Administrator indique une expertise en implémentation, gestion et surveillance d’un environnement Azure.

Les utilisateurs de Google Cloud peuvent opter pour la certification Google Associate Cloud Engineer, tandis qu’IBM propose le titre Certified Technical Advocate pour sa plateforme.

Hormis les fournisseurs, plusieurs organisations délivrent des certifications hautement reconnues. On peut citer pour exemple le Certificate of Cloud Security Knowledge (CCSK) de la Cloud Security Alliance, focalisé sur la sécurité du cloud.

Parmi les certifications destinées à des spécialistes de l’informatique, Microsoft Azure DP-203 s’adresse par exemple aux Data Engineers. Elle confirme l’aptitude à l’ingénierie des données sur le cloud, à l’aide de services tels que Spark, Azure Synapse SQL ou Azure Data Factory.

Pour obtenir ces certifications, il est toutefois nécessaire de réussir un examen. Suivre une formation cloud peut donc aider à se préparer, afin d’atteindre le succès dès la première tentative.

Comment suivre une formation cloud ?

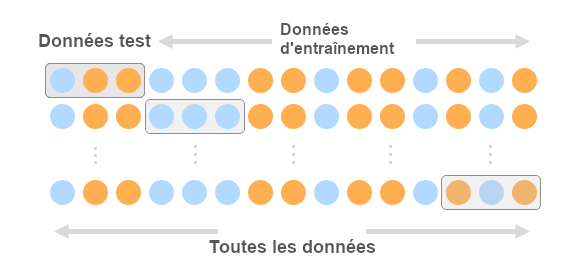

Il existe de nombreux cours, tutoriels, vidéos et autres simulateurs sur le web permettant d’apprendre les bases du cloud computing afin de pouvoir travailler avec cette technologie.

Par exemple, les MOOC (Massive Open Online Courses) sont des ressources populaires offertes gratuitement par les universités et d’autres organisations pour permettre à tout un chacun de s’initier à son rythme.

Les fournisseurs de services cloud tels que AWS, Microsoft Azure et Google Cloud Platform proposent également une documentation complète en ligne et des guides de formations pour apprendre à manier leurs plateformes respectives.

Toutefois, le meilleur moyen de la maîtriser est de suivre une formation complète. En choisissant DataScientest, vous pourrez compléter un cursus à distance afin d’acquérir une certification professionnelle AWS, Microsoft Azure ou Google Cloud.

Nos formations s’effectuent intégralement en ligne, et permettent d’assimiler toutes les compétences requises pour réussir l’examen de certification souhaité. Le passage de l’épreuve est compris dans le programme.

S’inscrire à une formation cloud

Conclusion : une formation cloud pour l’informatique de demain

Au fil des années à venir, le cloud computing va continuer à se démocratiser en entreprise. Cette technologie sera bientôt la principale approche de l’informatique.

Par conséquent, suivre une formation cloud permet d’acquérir une qualification tournée vers l’avenir. Les professionnels de AWS, Microsoft Azure et Google Cloud seront de plus en plus recherchés.

En choisissant DataScientest, vous mettez toutes les chances de votre côté pour obtenir une certification Microsoft Azure ou AWS.

Ce précieux titre vous permettra de démontrer votre maîtrise du cloud, et de vous distinguer des autres candidats auprès des employeurs.

Notre organisme détient les statuts officiels de Microsoft Learning Partner et AWS Training Partner, et nos formations sont éligibles au CPF pour le financement. Découvrez DataScientest !

Vous savez tout sur les formations cloud. Pour plus d’informations sur le même sujet, découvrez notre dossier complet sur le Cloud Computing et notre dossier sur les certifications cloud.