Le web est une véritable mine de données informatiques. Ces données peuvent être exploitées, analysées pour une infinité de cas d’usage et d’applications. On peut les utiliser pour nourrir des systèmes de Machine Learning, d’intelligence artificielle, ou tout simplement pour mettre en lumière des tendances et des phénomènes.

S’il est possible de collecter ces données manuellement afin de constituer de vastes datasets, cette tâche représente un travail de titan. Afin de l’automatiser, on utilise le Web Scraping.

Qu’est-ce que le Web Scraping ?

Le Web Scraping est un processus qui consiste à assembler des informations en provenance d’internet, à l’aide de divers outils et frameworks. Cette définition est très large, et même le fait de copier / coller les paroles d’une chanson peut être considéré comme une forme de Web Scraping.

Toutefois, le terme de Web Scraping désigne généralement un processus impliquant l’automatisation. Les volumes massifs de données sont collectés automatiquement, afin de constituer de vastes datasets.

Certains sites web s’opposent à la collecte de leurs données par des scrapers automatiques. En règle générale, le scraping à des fins éducatives est plus toléré que pour un usage commercial. Il est important de consulter les conditions d’utilisation d’un site avant d’initier un projet.

À quoi sert le Web Scraping ?

Le Web Scraping permet d’agréger des informations plus rapidement qu’avec une collecte manuelle. Il n’est plus nécessaire de passer de longues heures à cliquer, à dérouler l’écran ou à rechercher les données.

Cette méthode se révèle particulièrement utile pour amasser de très larges volumes de données en provenance de sites web régulièrement mis à jour avec du nouveau contenu. Le scraping manuel est une tâche chronophage et rébarbative.

À l’échelle individuelle, le Web Scraping peut se révéler utile pour automatiser certaines tâches. Par exemple, un demandeur d’emploi peut utiliser Python pour automatiser ses recherches d’offres. Quelques lignes de code permettent d’enregistrer automatiquement les nouvelles annonces publiées sur des plateformes comme Indeed ou Monster, afin de ne plus avoir à visiter ces sites web quotidiennement.

Le Web Scraping peut aussi être utilisé pour surveiller des changements de prix, comparer des prix, ou surveiller la concurrence en collectant des sites web en provenance de leurs sites web. Les possibilités sont nombreuses et diverses.

Toutefois, cette méthode se révèle surtout pertinente pour les projets Big Data nécessitant d’immenses volumes de données. Par exemple, l’entreprise ClearView AI a utilisé le Web Scraping sur les réseaux sociaux afin de constituer une immense base de données de photos de profils pour son logiciel de reconnaissance faciale.

Le Web Scraping est presque aussi vieux qu’internet. Alors que le World Wide Web fut lancé en 1989, le World Wide Web Wanderer a été créé quatre ans plus tard. Il s’agit du premier robot web créé par Matthew Gray du MIT. Son objectif était de mesurer la taille du WWW.

Les défis du Web Scraping

Depuis sa création, internet a beaucoup évolué. On y trouve une large variété de types et formats de données, et le web scraping comporte donc plusieurs difficultés.

Le premier défi à relever est celui de la variété. Chaque site web est différent et unique, et nécessite donc un traitement spécifique pour l’extraction d’informations pertinentes.

En outre, les sites web évoluent constamment. Un script de Web Scraping peut donc fonctionner parfaitement la première fois, mais se heurter ensuite à des dysfonctionnements en cas de mise à jour.

Dès que la structure d’un site change, le scraper peut ne plus être capable de naviguer la ” sitemap ” correctement ou de trouver des informations pertinentes. Heureusement, la plupart des changements apportés aux sites web sont minimes et incrémentaux, et un scraper peut donc être mis à jour avec de simples ajustements.

Néanmoins, face à la nature dynamique d’internet, les scrapers nécessitent généralement une maintenance constante. Il est possible d’utiliser l’intégration continue pour lancer périodiquement des tests de scraping et s’assurer que les scripts fonctionnent correctement.

Les APIs en guise d’alternative au Web Scraping

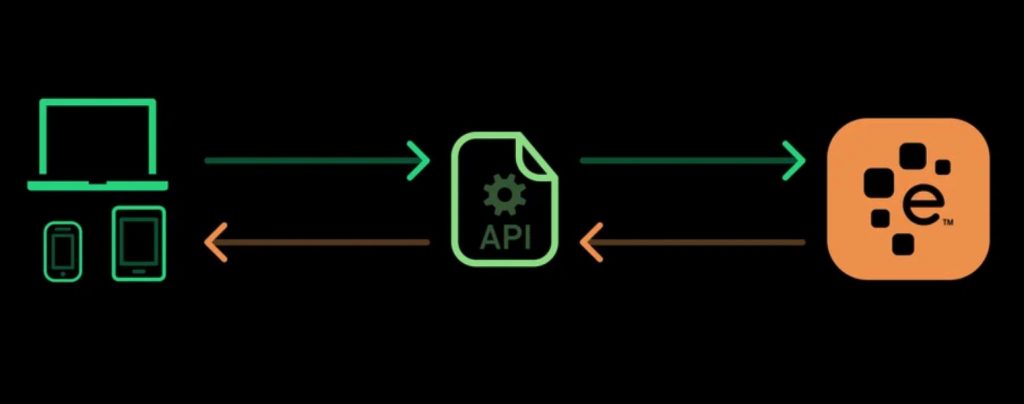

Certains sites web proposent des APIs (interface de programmation d’application) permettant d’accéder à leurs données de manière prédéfinie. Ces interfaces permettent d’accéder aux données directement en utilisant des formats comme JSON et XML, plutôt que de s’en remettre au parsing de HTML.

L’utilisation d’une API est en général un processus plus stable que l’agrégation de données via le Web Scraping. Pour cause, les développeurs créent des APIs conçues pour être consommées par des programmes plutôt que par des yeux humains.

La présentation front-end d’une site web peut souvent changer, mais un tel changement dans le design d’un site web n’affecte pas la structure de son API. Cette structure est généralement plutôt permanente, ce qui en fait une source plus fiable de données.

Néanmoins, les APIs aussi peuvent changer. Les défis liés à la variété et à la durabilité s’appliquent donc aussi bien aux APIs qu’aux sites web. Il est également plus difficile d’inspecter la structure d’une API par soi-même si la documentation fournie n’est pas suffisamment complète.

Qu’est-ce que Beautiful Soup ?

Beautiful Soup est une bibliothèque Python utilisée pour le Web Scraping. Elle permet d’extraire des données en provenance de fichiers XML ou HTML. Cette bibliothèque crée un arbre de parsing à partir du code source de la page, pouvant être utilisé pour extraire les données de manière hiérarchique et lisible.

À l’origine, Beautiful Soup fut introduite en mai 2006 par Leonard Richardson qui continue à contribuer au projet. En outre, le projet est soutenu par Tidelift et son outil de maintenance open-source proposé par abonnement payant.

En plus de ses hautes performances, Beautiful Soup apporte plusieurs avantages. Cet outil permet de parcourir les pages de la même manière qu’un navigateur, et enjolive le code source.

Comment apprendre à utiliser Beautiful Soup et Python ?

Afin d’apprendre à utiliser Beautiful Soup, vous pouvez choisir DataScientest. Leur formation Data Analyst commence avec un module dédié à la programmation en Python, et comporte un module dédié à l’extraction de données textes et au Web Scraping.

Les autres modules de ce cursus couvrent la Dataviz, le Machine Learning, les bases de données Big Data et la Business Intelligence. À l’issue du programme, vous aurez toutes les compétences requises pour exercer le métier de Data Analyst.

Toutes nos formations adoptent une approche Blended Learning combinant coaching individuel sur notre plateforme en ligne et Masterclass. Le programme peut être complété en Formation Continue ou en mode BootCamp intensif.

À la fin du cursus, vous recevrez un certificat délivré par l’Université Paris la Sorbonne dans le cadre de notre partenariat. Parmi les alumnis, 80% ont trouvé un emploi immédiatement après la formation.

Nos programmes sont éligibles au Compte Personnel de Formation pour le financement. N’attendez plus et découvrez la formation Data Analyst de DataScientest !

Vous savez tout sur Beautiful Soup. Découvrez notre dossier complet sur le langage Python, et notre dossier sur le métier de Data Analyst.