Un Plan de Reprise d’Activité (PRA) est essentiel dans une entreprise moderne pour assurer la continuité des opérations en cas de cyberattaque ou autre situation de crise. Découvrez tout ce que vous devez savoir sur cette pratique, et le rôle clé de l’analyse de données.

Face aux nombreux risques de cybersécurité et autres incidents imprévisibles, il n’est pas toujours simple d’assurer la continuité des activités pour une entreprise.

Or, une interruption prolongée des opérations peut avoir des conséquences financières désastreuses, mettre en péril la confiance des clients et nuire à la réputation d’une organisation.

Afin d’éviter une telle catastrophe, il est essentiel de mettre en place un dispositif dénommé PRA : Plan de Reprise d’Activité.

Qu’est-ce qu’un PRA ?

Il s’agit d’un ensemble de procédures et de stratégies, visant à minimiser les perturbations et à rétablir rapidement les opérations après un événement imprévu.

L’objectif principal est d’assurer la continuité des activités les plus critiques, mais aussi de protéger les actifs de l’entreprise et donc de réduire les pertes financières.

Souvent confondu à tort avec le Plan de Continuité des Activités (PCA), le PRA est pourtant un concept bien distinct.

Alors que le PCA vise à garantir la continuité des opérations dans des conditions de fonctionnement dégradées, le PRA se concentre spécifiquement sur la reprise après un événement perturbateur majeur.

Les étapes et composants du PRA

Pour être efficace, un PRA doit réunir plusieurs composants clés. La première étape est l’analyse et l’évaluation des risques potentiels auxquels l’entreprise est exposée.

Ceci implique d’identifier les menaces internes et externes, d’évaluer leurs impacts potentiels sur les opérations, et de prioriser les actions à entreprendre.

Après avoir cerné ces risques, la marche à suivre consiste à identifier les processus clés nécessitant d’être rétablis en priorité.

Il peut s’agir par exemple des activités telles que la production, la gestion des stocks ou encore la communication avec les clients. Tout dépend du secteur de l’entreprise et de son fonctionnement.

Pour chacun de ces processus critiques, des stratégies de reprise doivent être élaborées. On peut notamment mettre en place des sites de secours, sécuriser les sauvegardes des données ou élaborer des plans de rechange pour les principaux fournisseurs.

Pendant cette période de reprise, une communication efficace avec les parties prenantes internes et externes est cruciale. De fait, un plan de communication détaillé doit être établi pour informer les employés, les clients, les partenaires commerciaux, les autorités et les médias sur la situation et les mesures prises.

Afin de s’assurer que tout le personnel soit bien préparé à réagir, des formations et des opérations de sensibilisation sont indispensables. Des équipes de gestion de crise doivent aussi être désignées et préparées pour prendre les décisions appropriées en cas d’incident.

Enfin, l’efficacité du PRA doit être régulièrement vérifiée. Ceci passe notamment par des exercices de simulation et des tests pratiques visant à évaluer sa fiabilité et à identifier les éventuelles lacunes à corriger.

Quels sont les avantages pour l’entreprise ?

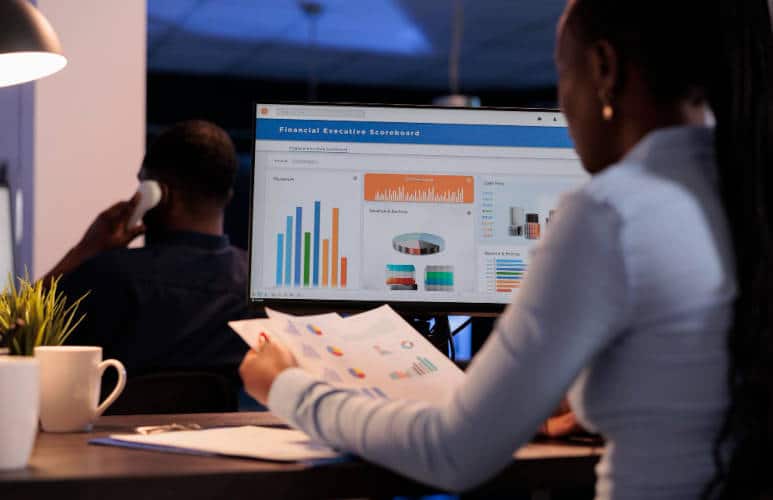

En ayant un plan de reprise clair et exécuté à la lettre, les entreprises minimisent les temps d’arrêt et les pertes liées aux incidents. La reprise rapide des opérations limite les effets négatifs sur les revenus et la productivité.

C’est aussi un moyen de maintenir la confiance des clients, partenaires et investisseurs. L’entreprise reste capable de fournir produits et services de manière cohérente, même après un événement perturbateur.

Pour les entreprises de secteurs soumises à des réglementations et normes de conformité, un PRA aide à s’assurer que ces obligations légales soient respectées. Ceci peut éviter de lourdes sanctions et des litiges potentiels.

Enfin, une réaction rapide et efficace en situation d’urgence renforce la réputation et l’image de marque d’une organisation. Elle démontre qu’elle est digne de confiance et résistante face aux aléas.