Si votre entreprise a acquis une certaine envergure, il est possible qu’elle soit concernée par la nouvelle directive européenne CSRD. Celle-ci a trait aux performances en matière de développement durable : celles-ci doivent désormais faire l’objet d’un reporting spécifique. Qui est concerné par cette directive ? Et que faire pour affronter cette nouvelle charge administrative de taille ?…

Vous le savez sans doute : l’Europe s’est fixé un objectif ambitieux. Celui de parvenir à la neutralité carbone d’ici 2050. Dans le cadre de ce vaste programme qui touche de nombreux secteurs d’activité, en avril 2021, la Commission Européenne a initié le CSRD, soit une réglementation qui contraint les entreprises d’une certaine envergure à un reporting lié à leurs actions durables. En bref, nous avons là une incitation forte à opérer de façon vertueuse. Et oui… L’Europe a à cœur d’encourager les initiatives allant dans le sens de la protection de l’environnement. Mais commençons par le commencement.

CSRD, ça veut dire quoi au juste ?

CSRD est l’abréviation de Corporate Sustainability Reporting Directive. Mais encore ? Dans la langue de Molière, cela nous donne : Directive sur les Rapports de Développement Durable des Entreprises.

Prendre en compte les enjeux climatiques

Toute l’idée est donc d’inciter les entreprises à prendre en compte les enjeux climatiques et sociétaux dans leurs efforts de développement. Parmi les objectifs fixés figurent :

- Encourager les investissements durables, par l’usage de matériaux recyclables, de composants peu énergivores, etc.

- Lutter contre le greenwashing, cette pratique de marketing mise en œuvre par certaines entreprises pour donner l’impression qu’elles agissent en faveur de l’environnement alors que ce n’est pas réellement le cas.

Dans la pratique, cette directive se traduit par l’obligation, pour des entreprises ayant atteint une certaine taille, de pratiquer un reporting « extra-financier » (non lié à leurs performances économiques), ayant trait à leur impact environnemental et leurs actions dans le sens de la durabilité.

Une directive contraignante

Le CSRD fait suite à l’adoption au niveau européen de 12 normes regroupées sous le label ESRS, soit European Sustainability Reporting Standards ou normes européennes d’information en matière de durabilité. Pour faire simple, nous avons là une tentative:

- d’uniformiser les critères relatifs aux activités environnementales, car jusqu’alors, à la différence des informations financières, elles n’étaient pas bien normalisées avec notamment de multiples labels.

- de favoriser la transparence, afin d’éviter les tentatives de greenwashing. Avec des critères qui se veulent a priori compréhensibles par tous, et donc plus accessibles.

- de faciliter la comparaison entre les entreprises. Le CSRD va aider à distinguer les entreprises performantes en matière de durabilité.

Pour celui qui dirige une société, voir débarquer de nouvelles contraintes n’est jamais appréciable. Autant le savoir, les questions auxquelles il faut répondre de manière obligatoire sont plus de trois cent – 10 thématiques sont optionnelles. L’entreprise doit préciser quel est son domaine d’activité et sa chaîne de valeur, mais aussi indiquer une feuille de route quant à la gestion de son impact écologique. Voilà donc bien une charge importante pour l’entreprise, sachant qu’elle est déjà tenue à un reporting sur ses performances financières.

Pourquoi ajouter de nouvelles servitudes, assorties de sanctions et d’amendes en cas de non conformité, diront certains ? Il apparaît que l’urgence de prendre des mesures de protection de la planète, telle que l’ont souligné les études menées par des organismes tels que le GIEC, a primé. Et donc, il ne paraît pas possible de s’y soustraire dès lors qu’on entre dans les critères de sélection…

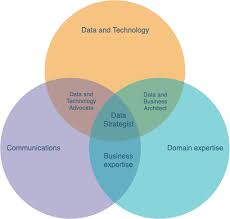

Se former au CSRD sur Power BI

Quelles entreprises sont concernées ?

Bien évidemment, la question qui va poindre est celle-ci : mon entreprise est-elle concernée, et à quelle échéance ? Commençons par une nouvelle rassurante : même si le CSRD est entré en vigueur au début de 2024, les premiers rapports sont attendus pour le début 2025. Ce qui revient à dire que les intéressés vont disposer d’une année pour apprivoiser ces nouvelles normes. Et ce n’est pas de trop, si l’on en croit ceux qui ont commencé à s’y frotter, car le CSRD est présenté comme fort complexe. Certains spécialistes évoquent un vaste bouleversement, notamment dans les PME, qui accusent une forte impréparation sur un thème tel que l’évaluation de leur bilan carbone. D’autres experts affirment qu’il est quasi impossible de répondre à toutes les questions demandées par le CSRD et qu’il faut y aller progressivement.

En réalité, il existait déjà depuis 2014 une obligation de reporting intitulé la NFRD (Non Financial Reporting Directive), mais elle ne touchait que 11000 entreprises – comptant plus de 500 salariés -, et montrait des insuffisances sur divers points.

Alors qui est concerné par la CSRD et qui en est exempté ? Près de 55 000 entreprises au total…

Les sociétés cotées en Bourse

Les sociétés cotées sur les marchés réglementés doivent assurer le reporting CSRD, à l’exclusion toutefois des micro-entreprises, soit celles employant moins de 11 salariés. Pour ce qui est des PME cotées, il est bon de savoir que cette catégorie d’entreprise bénéficie d’obligations de reporting allégées.

Les entreprises européenne d’une certaine taille

Trois critères sont pris en compte ici. Dès lors que deux d’entre eux, sont satisfaits, l’entreprise entre dans le cadre du CSRD:

- plus de 250 salariés,

- 40 millions d’euros de chiffre d’affaires,

- 20 millions d’euros au bilan.

Les grandes entreprises non européennes

Les entreprises extra-européennes qui réalisent un chiffre d’affaires de 150 millions d’euros sur le sol européen sont concernées par le CSRD.

La morale de cette histoire…

Il en est ainsi. Les entreprises ne sont plus appelées à briller par leurs seuls résultats économiques. Elles doivent désormais montrer qu’elles sont performantes au niveau de leurs responsabilités sociales et environnementales. À chacun de transformer cette obligation en opportunité de développements. Après tout, il n’est pas rare que de simples individus s’interrogent aujourd’hui sur les actions réalisées par une entreprise donnée en termes de biodiversité et sujets annexes. Et de plus en plus, ces critères peuvent peser sur le choix d’un prestataire donné.

Alors, en s’habituant à un reporting précis en la matière, une entreprise va pouvoir mieux répondre à de telles questions et parfois emporter certains contrats pour lesquels la décision ne tenait qu’à quelques points distinctifs.