Il est de plus en plus fréquent de trouver des offres d’emploi qui recherchent des spécialistes de la gestion de gros volumes de données ou plus précisément des experts en Big Data. Considéré comme l’un des métiers les plus prometteurs du 21e siècle, l’expert Big Data se présente comme la nouvelle spécialité la plus demandée par les entreprises pour transformer les données en connaissances. Dans cet article, nous apportons des explications sur les emplois les plus demandés dans le Big Data.

Pourquoi les entreprises recherchent-elles différentes spécialités dans le Big Data ?

Il existe de nombreux emplois dont les entreprises n’ont pas besoin pour plusieurs raisons. Cependant, il y en a de nouveaux qui surgissent en raison des besoins exigés par la transformation numérique.

Dans un environnement qui évolue si rapidement sur le plan technologique, les entreprises recherchent de plus en plus des spécialistes capables de travailler avec les gros volumes de données stockés chaque jour. Ces données, dûment analysées et traitées sont en réalité des informations très utiles et représentent de nouvelles opportunités commerciales, des aides dans les prises de décision, une connaissance plus précise du public cible, etc.

Cependant, il y a un manque de personnes spécialisées dans le Big Data sur le marché actuel du travail. Néanmoins, ceux qui sont formés dans ce domaine ont devant eux une opportunité unique et un net avantage dans le domaine professionnel.

Les métiers Big Data les plus recherchés

En raison de l’arrivée d’un besoin total de transformation numérique au sein des entreprises, celles qui n’ont pas encore fait la transition font face aux nouveaux besoins technologiques du Big Data :

- Collecte de données

- Gestion des données

- Analyse de données

- Traitement de données

Une fois qu’elles sont converties en informations, elles peuvent les utiliser pour comprendre le comportement de leurs clients et prendre des décisions stratégiques.

La demande pour les différents profils de métier Big Data s’est également reflétée dans les classements des organismes de recrutement où des postes tels que le data scientist ou le data analyst figurent parmi les dix les plus demandés par les entreprises.

Mais, tous les emplois dans le Big Data n’ont pas le même profil ou n’effectuent pas les mêmes fonctions. Il existe différentes spécialités dans le metier Big Data. Ci-dessous, nous avons listé les spécialités du métier Big Data les plus demandés par les entreprises.

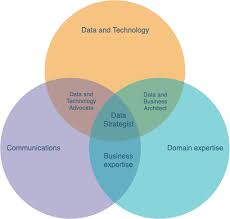

1. Chief data officer (CDO)

Il est responsable de toutes les équipes spécialisées dans le Big Data au sein de l’organisation. Sa fonction est de diriger et de gérer les données et les analyses associées à l’activité. Il doit également veiller à ce que l’entreprise soit axée sur les données. En d’autres termes, il est chargé d’exploiter les actifs de données pour créer de la valeur commerciale.

Le rôle d’un CDO combine l’obligation de rendre compte et la responsabilité de la confidentialité et de la protection des informations, de la qualité des données et de la gestion des données. Il s’agit du directeur numérique de l’entreprise. C’est un personnage clé, car ce professionnel est le directeur numérique de l’entreprise.

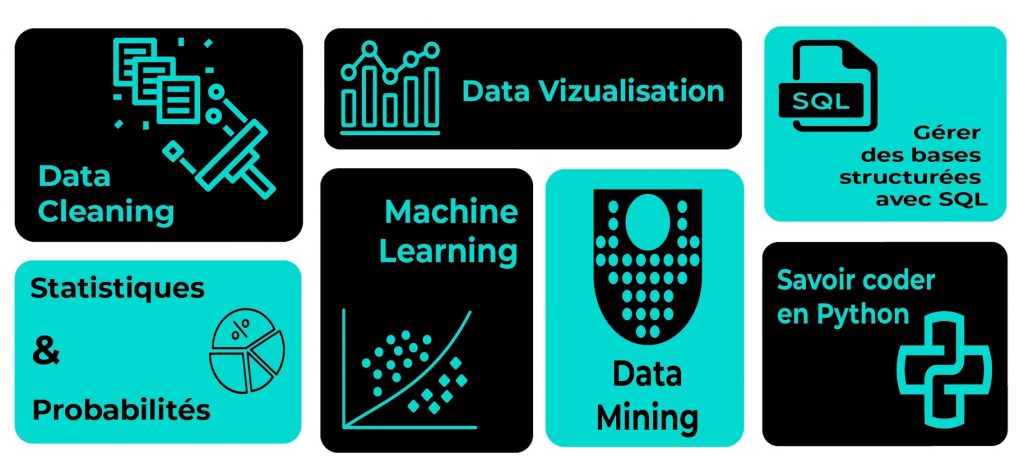

2. Data Scientist

Sa fonction consiste à traduire de grands volumes de données et à les convertir en informations utiles pour l’entreprise. Il/elle a des connaissances en mathématiques, statistiques et informatiques (Intelligence artificielle, Machine Learning, etc.). Il a également une vision de l’entreprise et des compétences en communication pour pouvoir faire part des résultats de son travail au reste de l’organisation.

Le data scientist est un autre profil qui est très demandé dans tous les domaines du numérique. Il n’est donc pas surprenant que les entreprises aient du mal à trouver ces professionnels spécialisés sur le marché du travail. Ils ont pour rôle d’apporter des réponses fiables aux problèmes quotidiens. Par exemple, savoir quel est le meilleur moment pour acheter un billet d’avion.

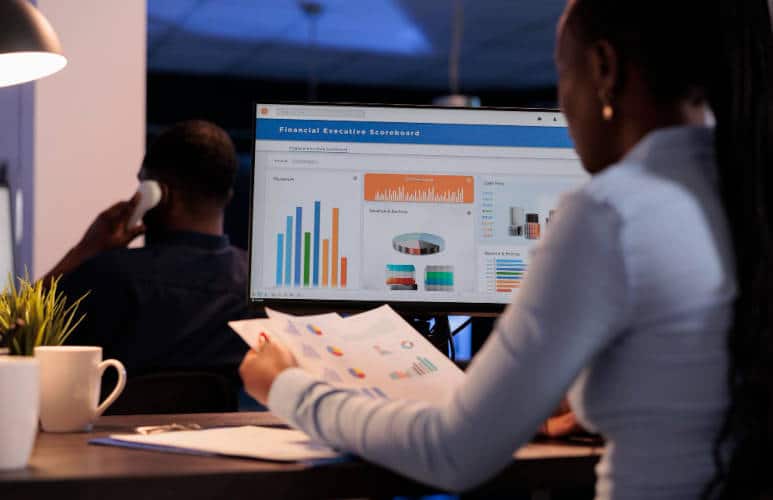

3. Data analyst

Comme son poste l’indique, il participe à l’analyse des données et recueille les besoins des clients pour les présenter au data scientist. Il est également en charge de :

- L’extraction, le traitement et le regroupement des données

- L’analyse de ces groupes de données

- La production de rapports détaillés

L’analyse des données est devenue une pratique incontournable dans les stratégies marketing des entreprises. Pour cette raison, elle nécessite des professionnels capables non seulement d’extraire ces données, mais de les interpréter.

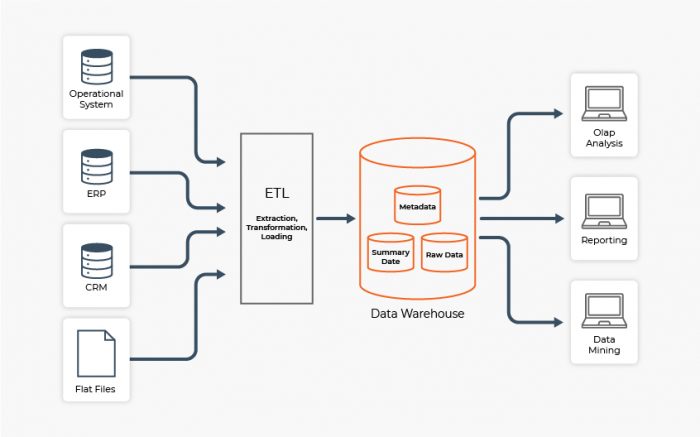

4. Data engineer

La tâche de l’ingénieur des données consiste à distribuer les données de manière accessible aux Data Scientists. Son profil est plus spécialisé dans la gestion de bases de données et dans les systèmes de traitement et de programmation. Nous pourrions définir un data engineer comme un professionnel axé sur la conception, le développement et la maintenance de systèmes de traitement de données dans le cadre d’un projet Big Data.

Son objectif est de créer et de maintenir les architectures et les structures technologiques nécessaires au traitement, à l’assimilation et au déploiement à grande échelle d’applications gourmandes en données.

En bref, il conçoit et construit des pipelines de données brutes. À partir de là, il collecte, transforme et prépare les données pour l’analyse.

5. Data manager

Le rôle principal d’un data manager est de superviser les différents systèmes de données d’une entreprise. Il est chargé d’organiser, de stocker et d’analyser les données de la manière la plus efficace possible.

Le gestionnaire de données possède des connaissances en informatique et 1 à 4 ans d’expérience dans sa spécialité. Il se démarque dans le monde des chiffres, des enregistrements et des données brutes. Mais, il doit également être familiarisé avec l’ensemble du système de données. Parallèlement, il doit avoir un esprit logique et analytique avec de bonnes compétences en résolution de problèmes.