Jusqu’à présent, les données sont la meilleure source de connaissances pour les entreprises. En effet, elles en génèrent plus que jamais, d’où l’apparition du terme Big Data. Cependant, accumuler de telles quantités d’informations numériques à très peu d’utilité à moins que ces organisations en comprennent le sens. C’est là qu’interviennent les logiciels de Business Intelligence en self-service tels que Power BI.

Qu’est-ce que Power BI ?

Power BI est le nom commun attribué à une variété d’applications et de services basés sur le Cloud. Ces derniers sont conçus pour aider les entreprises à collecter, gérer et analyser diverses sources de données via une interface facile à utiliser. Il permet de rassembler les données et de les traiter. Mais surtout, il est utile pour transformer les données en informations intelligibles souvent à l’aide de graphiques et de tableaux visuellement précis et faciles à traiter. Cela permet aux utilisateurs de créer des rapports interactifs et de les partager à toutes les parties prenantes d’une entreprise.

Cette application Microsoft se connecte à une variété de sources de données. Il peut s’agir de feuilles de calcul Excel ou de bases de données sur un data warehouse. Il peut également se connecter à des applications à la fois dans le Cloud et sur les serveurs de l’entreprise.

Cette appellation est un terme général et peut faire référence à une application de bureau Windows appelée Power BI Desktop. Il peut s’agir d’un outil ETL (Extract, Transform and Load) dénommé Power Query ou d’un service en ligne SaaS (Software as a Service) appelé Power BI Service. Il peut aussi s’agir d’applications mobiles Power BI pour les Smartphones et tablettes Windows ainsi que pour les appareils iOS et Android.

Power BI est basé sur Microsoft Excel. En tant que tel, la courbe d’apprentissage d’Excel vers Power BI n’est pas si raide. Quiconque peut utiliser Excel peut utiliser Power BI. Mais, ce dernier est beaucoup plus puissant que la feuille de calcul.

Que fait cette application d’analyse de données ?

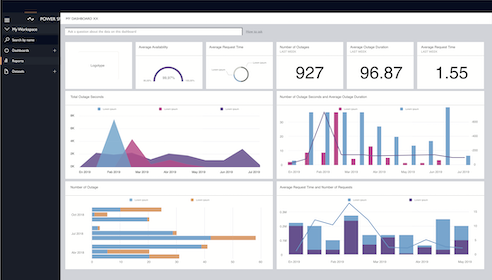

Dans tout environnement d’entreprise, il est essentiel d’unifier toutes les informations disponibles autour d’une même plateforme que ce soit dans le Cloud ou en local. Pour ce faire, Power BI est l’outil idéal. Il permet d’appliquer les connaissances de la Business Intelligence (BI) en exploitant des données en temps réel provenant de différentes sources et en créant des rapports. Sur un simple tableau de bord se trouvent les résultats de tous les éléments à analyser et partager entre plusieurs professionnels d’une même entreprise.

En effet, cette application d’analyse de données est utilisée pour la création de rapports basés sur les données de l’entreprise. En utilisant Power BI, l’utilisateur peut se connecter à un large éventail d’ensembles de données et classer les informations fournies par le biais de la data visualisation afin qu’elles puissent être mieux comprises et assimilées. Le tableau de bord généré à partir de ces données peut être partagé avec d’autres utilisateurs.

Power BI aide les entreprises à voir non seulement ce qui s’est déroulé dans le passé et ce qui se passe dans le présent, mais également ce qui pourrait se produire dans le futur. Cet outil d’analyse de données est doté de fonctionnalités d’apprentissage automatique. Il permet ainsi à son utilisateur de détecter un modèle de données et d’utiliser ce modèle pour effectuer des prédictions éclairées et exécuter des scénarios de simulation. Ces estimations permettent à l’entreprise pour laquelle il travaille de générer des prévisions. Elle aura ainsi la capacité de se préparer à répondre à la demande future et à adopter des mesures clés.

6 raisons d’utiliser Power BI

Pour les entreprises qui souhaitent plus de puissance de reporting et de force analytique que ce qu’offre Excel, Power BI est à un tout autre niveau du Business Intelligence. Avec cet outil, les entreprises peuvent collecter, analyser et visualiser l’ensemble de leurs données, ce qui leur donne un meilleur aperçu de leur productivité et de leur compétitivité. Ainsi, elles peuvent prendre des décisions plus éclairées basées sur des données réelles.

Pour mieux comprendre la puissance de Power Bi, voici quelques-uns de ses principaux avantages :

- Les entreprises peuvent gérer de grandes quantités de données via cette application qu’en utilisant d’autres plateformes d’analyse de données.

- Les informations peuvent être visualisées à l’aide de modèles afin que les entreprises puissent mieux comprendre leurs données.

- Il est basé sur le service Cloud de sorte que les utilisateurs bénéficient de capacités d’intelligence de pointe et d’algorithmes puissants régulièrement mis à jour.

- Plusieurs personnalisations permettent aux utilisateurs de créer des tableaux de bord afin d’accéder rapidement aux données dont ils ont besoin.

- Il propose une interface intuitive qui le rend beaucoup plus facile à utiliser que les feuilles de calcul complexes.

- Il garantit la sécurité des données en offrant des contrôles d’accessibilité internes et externes.

Pour résumer, Power BI est la solution professionnelle pour visualiser et transformer les données. Mais, il sert surtout à partager des informations avec tous les services de l’entreprise, de manière efficace et rapide. Grâce à ses tableaux de bord intuitifs et à son contrôle d’accessibilité, tout le monde dispose d’informations en temps réel. Toutes les parties prenantes pourront les consulter à tout moment et en tout lieu.

L’analyse des données pour soutenir la prise de décision

Power BI est l’un des plus pratiques et performants outils Microsoft pour l’analyse de données. Il s’est imposé comme le leader du secteur. Il reflète d’ailleurs les connaissances et l’expérience de Microsoft dans ce domaine à travers des solutions telles qu’Excel ou SQL Server et ses compléments (SSAS, SSIS et SSRS).

Power BI facilite la transformation des données en informations grâce à des modèles analytiques. Cela va de l’information à la connaissance en passant par des rapports analytiques avec des graphiques, des tableaux, etc. L’objectif de Microsoft est d’offrir un outil de prise de décisions intelligentes en réduisant les risques. Il apporte une réponse efficace aux besoins d’un des professionnels qui interviennent dans ce domaine : le data analyst.

À part cela, Power Bi est également un outil multiplateforme pour la surveillance de l’entreprise en temps réel par les parties prenantes partout et à tout moment.

L’autre atout de Power BI dans l’analyse des données est son intégration totale avec la suite Office 365. Il donne accès à SharePoint, à un calendrier, à Microsoft Flow pour les flux de travail et à une longue liste de fonctionnalités et de possibilités sans quitter l’environnement Office 365.

Par ailleurs, Microsoft s’est fortement engagé envers les techniques d’apprentissage automatique. Power BI offre de multiples fonctionnalités dans ce domaine :

- L’analyse automatique des informations

- Le calcul des corrélations

- L’identification de valeurs aberrantes

- Le regroupement

- L’intégration de Python pour l’importation de données et la création de graphiques

- Etc.