En mars 2020 l’Institut Montaigne diffusait une étude sur le contrôle des biais. La semaine dernière, c’est un groupement d’environ une soixantaine de chercheurs d’institutions, d’entreprises américaines et européennes spécialisés autour de l’intelligence artificielle ou IA (École Normale Supérieure de Paris, Alan Turing Institute, Cambridge, Stanford, Oxford, Google, Berkeley, Intel, etc.) qui a publié un rapport appelant au contrôle de l’éthique des IA.

Depuis quelques temps déjà, ce besoin d’encadrement est régulièrement évoqué, voir notre article « Ethique ou Big Data ». De nombreux rapports ont déjà été édités explicitant les différents problèmes éthiques de l’IA. Dans ces deux derniers rapports sont encore pointés ces mêmes problèmes, comme le contrôle des biais, la mise en place de bonnes pratiques communes mais aussi le manque de soutien financiers des politiques publiques pour financer la recherche à ce sujet.

Afin d’assurer un développement de l’IA efficient tout en respectant les droits fondamentaux de chacun est devenu une urgence, la crise sanitaire et les différentes problématiques que l’utilisation des données a pu engendrer au niveau éthique va, espérons-le, certainement accélérer cet encadrement des pratiques de l’IA.

Dans son étude l’Institut Montaigne incite plus à la prévention et à la sensibilisation qu’à la régulation et la sanction.

Les 4 recommandations qui ont été mises en avant par l’Institut sont les suivantes :

- Tester la présence de biais dans les algorithmes comme l’on teste les effets secondaires des médicaments.

- Promouvoir une équité active plutôt que d’espérer l’équité en ne mesurant pas la diversité.

- Être plus exigeant pour les algorithmes ayant un fort impact sur les personnes (droit fondamentaux, sécurité, accès aux services essentiels)

- Assurer la diversité des équipes de conception et de déploiement des algorithmes

L’institut préconise également l’émergence de labels qui garantissent la qualité des données utilisées et de l’organisation qui développe l’algorithme, l’existence de procédures de contrôle ou encore l’audibilité de l’algorithme, une capacité d’audit et de contrôle de certaines exigences pourrait être confiée à une tierce partie ou à l’État.

Dans le rapport publié la semaine dernière par le groupement de divers spécialistes internationaux de IA, on retrouve quasi la même préconisation parmi les 10 préconisées :

« Les organismes de normalisation doivent travailler avec les universités et l’industrie pour développer des exigences d’audit pour les applications critiques des algorithmes. »

Ce rapport préconise également d’autres pistes comme la mise en place de « bias bounty », d’une mutualisation des travaux et des outils entre organisations, en effet à l’heure actuelle chaque entreprise, université, s’applique des normes éthiques qui lui sont propres ce qui peut entrainer de nombreuses dérives.

Au niveau de l’état français, ce besoin d’encadrement est bien pris en compte puisqu’un budget de 30 M€ a été alloué à la certification de l’IA pour éviter les biais liés aux algorithmes (évaluation éthique des algorithmes, consolidation des algorithmes grâce à un dispositif de certificabilité) comme évoqué dans notre article « État et IA: une union en bonne voie? »

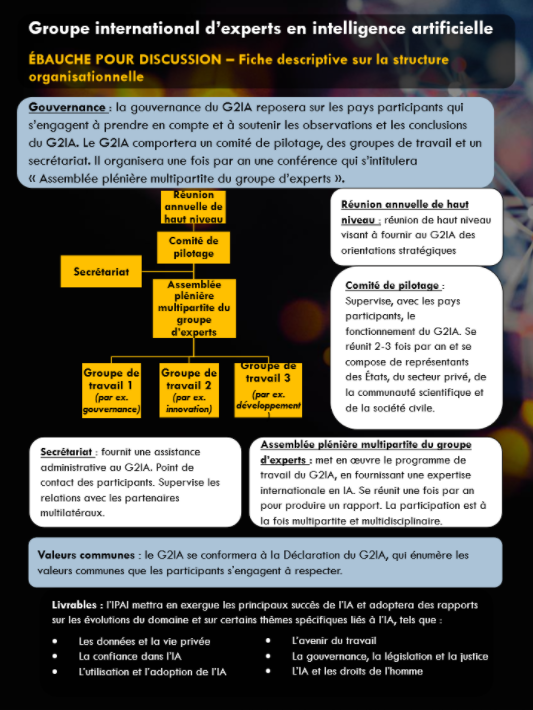

Déjà depuis 2018, conscients de la nécessité d’une coopération et d’une coordination à l’échelle internationale pour exploiter le plein potentiel de l’IA ,le Canada et la France dans le cadre du G7, travaillent ensemble aux côtés de la communauté internationale à la création d’un groupe international d’experts sur l’intelligence artificielle (G2IA ou IPAI, pour international panel on artificial intelligence ) , sur le même modèle que le GIEC, pour favoriser la collaboration et la coordination internationale.

Ce groupement d’experts devra s’engager à respecter les valeurs communes suivantes lors du développement, de l’adoption et de l’utilisation de l’IA :

- Promouvoir et protéger une approche de l’IA à la fois éthique et centrée sur l’humain, fondée sur les droits de l’homme ;

- Promouvoir une approche multipartite de l’IA ;

- Stimuler l’innovation, la croissance et le bien-être à travers l’IA ;

- Mettre les travaux sur l’IA en adéquation avec les principes de développement durable et la réalisation du Programme développement durable à horizon 2030

- Renforcer la diversité et l’inclusion à travers l’IA ;

- Favoriser la transparence et l’ouverture des systèmes d’IA ;

- Favoriser la confiance et la redevabilité en matière d’IA ;

- Promouvoir et protéger les valeurs, les procédures et les institutions démocratiques ;

- Combler les fractures numériques ;

- Promouvoir la coopération scientifique internationale dans le domaine de l’IA.

Le 22 mai 2019 c’étaient les 36 pays membres de l’OCDE, ainsi que l’Argentine, le Brésil, la Colombie, le Costa Rica, le Pérou et la Roumanie qui ont adhéré aux Principes de l’OCDE sur l’intelligence artificielle. Principes élaborés avec le concours d’un groupe de plus de 50 experts de tous horizons – administrations, milieux universitaires, entreprises, société civile, instances internationales, communauté technique et organisations syndicales.

La conclusion évidente, à la vue de ces nombreux rapports émanant d’experts, de principes sur les bons usages de l’IA prescrits par diverses institutions, ou de la création du G2IA est que l’ensemble des acteurs économiques a un besoin urgent de repères communs afin de pouvoir se saisir pleinement et en toute légalité du potentiel de l’IA. La société numérique de demain a besoin de ce cadre pour pouvoir grandir et se développer sur des bases saines.